Home » TPT » Cloud Testing mit TPT: Fallstudie mit AGSOTEC » Technische Aspekte im Cloud Testing » Umsetzung Fall 1

Umsetzung Fall 1

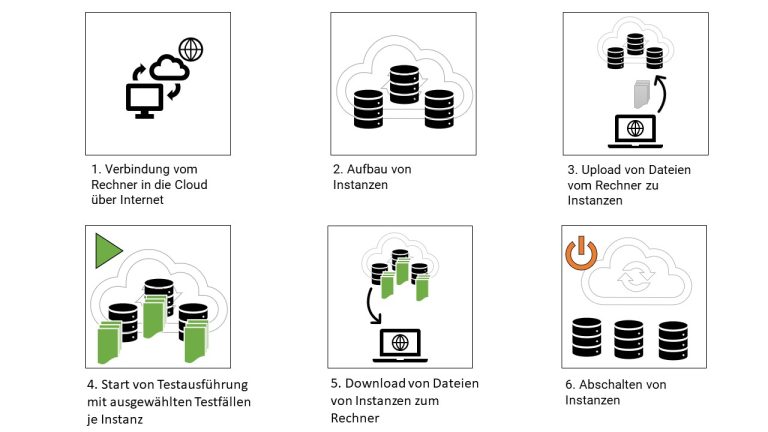

Wir untersuchen die Reduzierung der Testausführungszeit auf ein Minimum durch Nutzung mehrerer paralleler Recheneinheiten.

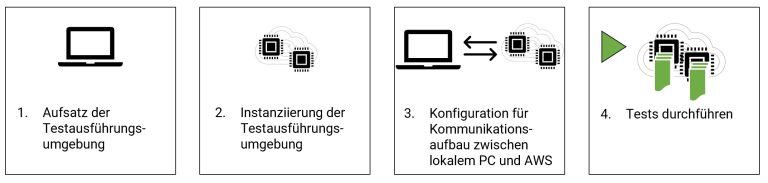

Der User startet in dem Fall initial den Testlauf.

Der User startet in dem Fall initial den Testlauf.